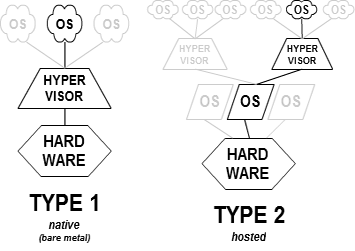

La virtualisation pour tenter de simplifier, pourrait correspondre à plusieurs "couches d'émulation", crées à l'aide d'API, permettant l'accès aux interfaces de gestions et de communications de serveurs virtuels. La virtualisation puise dans les composants hardware les ressources nécessaires pour émuler les OS et les interfaces réseaux. Ces systèmes d'exploitation sont installés en natif, à savoir directement sur l'hyperviseur ou virtualisation de type 1. Les systèmes sont "montés" à partir d'images ISO. Cela rend possible l'installation d'un hyperviseur su un OS hôte ou système d'exploitation invité qu'on appelle la virtualisation de type 2. Une fois installé, l'hyperviseur émulera en fonction des ressources, des Machines virtuelles, puis à l'aide de modules ou "add on", le réseau avec des cartes virtuelles. Les cartes virtuelles permettront de connecter les divers noeuds de votre architecture ainsi que les services Cloud.

La virtualisation Bare Metal (type 1) est mieux adaptée aux importantes charges réseaux et tâches systèmes en plus d'être mieux sécurisé.L'image çi-dessous résume la différence.

- Type 1, solution hyperviseur native bare metal hébergant les Machines virtuelles

- Type 2, invité ou hosted sur système avec un hyperviseur implémenté

Par conséquent, pour utiliser la virtualisation il convient de bien dimensionner le serveur qui hébergera l'hyperviseur. Il pourra interagir avec d'autres hyperviseurs, voir créer un cluster. L'administration des machines virtuelles via vSphere et vCenter pour VMware, Hyper-V pour Microsoft, XenCenter et XenServer pour Citrix, utilisent le chiffrement et les "Certificate Authority" (VMware VMCA) qui permettent de relier, d'accéder aux systèmes. Les hyperviseurs de type 1 sont plus utilisés en production que les hyperviseurs de type 2 utiles pour créer des laboratoires de test ou "lab tests".

Pour IBM, créateur de la virtualisation cette technologie représentait un processus qui allait permettre une utilisation plus éfficace du matériel informatique et allait poser les bases du Cloud Computing. VMWare et ses hyperviseurs ont par la suite transformés radicalement l'utilisation des appliances en optimisant le stockage (SAN). Avec le premier logiciel, Workstation 1.0 en 1999, suivi d'une offre tous les 2-3 ans. ESX Server 1.5 arrive en 2002, en consolidant plusieurs serveurs sur un terminal physique. Cela permet d'améliorer les performances, en simplifiant l’administration et en permettant aux entreprises de réduire leurs coûts de production et d'améliorer le Retour Sur Investissement ou ROI. VMware se taillera, plus tard, une part importante du marché avec plusieurs acquisitions et deviendra l'acteur majeur de la virtualisation et de la gestion des terminaux mobiles. Ainsi, naturellement, VMware ESX(i), vSphere et vCenter avec à la demande croissante de l’utilisation des Terminaux Personnels (BYOD pour Bring Your Own Device) permet de gérer et de contrôler ses nouveaux environnements.

DANS UN CONTEXTE EN PRODUCTION TIRAILLE ENTRE

La nécessité d’être innovant pour anticiper les besoins et déployer de nouveaux services,

La nécessité d'assurer la conformité des systèmes et des applications,

La nécessité d'optimiser les performances

ainsi que les coûts pour assurer de meilleurs "Retour Sur Investissement" (ROI ou Return On Investment).

Pour améliorer la productivité

En optimisant les services de support, de gestion d'actifs (ITSM et CMDB)

En fournissant un service de retour d'expérience et de qualité à l'aide de Groupware.

En sécurisant les VM (CLOUD, VLAN, VPN et SD-WAN, IDS pour tests d'intrusions)

En assurant la mise en oeuvre de PRA "Plans de Retour d'Activité" pour serveurs physiques et virtuels.

LES AVANTAGES DE LA VIRTUALISATION

La virtualisation est depuis quelques années en pleine expansion, et pour cause : la consolidation des serveurs a de nombreux avantages, comme la réduction des coûts énergétiques (véritablement problématique dans les Datacenters), l’optimisation de l’espace, mais aussi une énorme souplesse dans le "provisionnement" et la gestion des sauvegardes et restaurations (snapshot).

![]() La Virtualisation a fait son apparition dans les environnements d'entreprises pour virtualiser des serveurs, les applications, le stockage et les environnements de travail.

La Virtualisation a fait son apparition dans les environnements d'entreprises pour virtualiser des serveurs, les applications, le stockage et les environnements de travail.

A l'instar des hyperviseurs "bare-metal" de type-1, utilisés pour les serveurs tels que VMware ESX vSphere, Citrix XenServer ou Microsoft Hyper-V. Les hyperviseurs s'exécutent maintenant directement sur le poste client et permettent d'héberger différents systèmes d'exploitation. Une couche d'abstraction matérielle est placée entre le système d'exploitation virtualisé et le système d'exploitation de la machine physique (l'hôte) ou directement sur la machine physique elle-même (dans le cas de solution Bare Metal). Cette couche d'abstraction dispose de périphériques virtuels émulant les périphériques physiques d'une machine. Ainsi, le système d'exploitation pense en tout point s'exécuter sur un serveur physique. Dans les architectures de type hébergée, la couche de virtualisation tourne en tant qu'application sur le système d'exploitation de la machine physique. Cette architecture supportant un grand nombre de configurations matérielles est la plus flexible et la plus simple à mettre en œuvre. Dans les architectures de type Bare Metal, la couche d'abstraction (que l'on nomme hyperviseur dans ce cas) est installé directement sur le matériel. Disposant d'un accès direct au matériel, cette architecture fournit de meilleures performances. Autrefois jugée impossible, la virtualisation des serveurs x86 s'est développée autour de plusieurs techniques complémentaires :

![]() La virtualisation totale utilisant la translation binaire (Full virtualization & Binary Translation)

La virtualisation totale utilisant la translation binaire (Full virtualization & Binary Translation)

![]() La virtualisation assistée par le système d'exploitation ou para-virtualisation

(Os assisted virtualization). Le système d'exploitation

virtualisé est modifié spécifiquement pour la

virtualisation.

La virtualisation assistée par le système d'exploitation ou para-virtualisation

(Os assisted virtualization). Le système d'exploitation

virtualisé est modifié spécifiquement pour la

virtualisation.

![]() La virtualisation assistée par matériel (Instructions Intel VT,

AMD-V)

La virtualisation assistée par matériel (Instructions Intel VT,

AMD-V)

Contrairement à une idée répandue, les différents produits actuellement disponibles pour virtualiser les systèmes x86 utilisent dans la plupart des cas une combinaison de ces techniques. La virtualisation des systèmes se confirme comme étant la révolution de cette décennie. Certains constructeurs de serveurs intègrent désormais un hyperviseur directement avec le serveur.

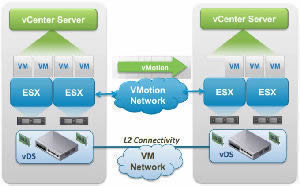

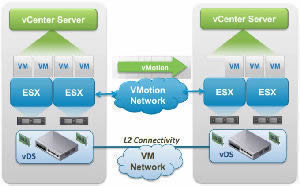

![]() La virtualisation est une couche d'abstraction qui découple le matériel physique du système d'exploitation pour permettre une meilleure utilisation des ressources informatiques avec une plus grande souplesse, tout en limitant les coûts et les risques liés à un sinistre majeur. Elle permet à plusieurs machines virtuelles dotées de systèmes d'exploitation hétérogènes de fonctionner de façon indépendante, côte à côte, sur la même machine physique. Chaque machine virtuelle possède son propre ensemble de matériel virtuel (RAM, processeurs, cartes réseau, stockage, etc.) à partir duquel sont chargés le système d'exploitation et les applications. Le système d'exploitation visualise un ensemble de matériel homogène et normalisé quels que soient les composants matériels physiques réels. Les machines virtuelles sont encapsulées dans des fichiers, ce qui permet de les enregistrer, copier et de les provisionner rapidement comme avec vSphere, vCenter et vMotion. Des systèmes complets (systèmes d'exploitation, applications configurées, et matériel virtuel) peuvent être transférés en quelques secondes d'un serveur physique à l'autre pour une maintenance sans interruption de service et une consolidation continue des charges de travail.

La virtualisation est une couche d'abstraction qui découple le matériel physique du système d'exploitation pour permettre une meilleure utilisation des ressources informatiques avec une plus grande souplesse, tout en limitant les coûts et les risques liés à un sinistre majeur. Elle permet à plusieurs machines virtuelles dotées de systèmes d'exploitation hétérogènes de fonctionner de façon indépendante, côte à côte, sur la même machine physique. Chaque machine virtuelle possède son propre ensemble de matériel virtuel (RAM, processeurs, cartes réseau, stockage, etc.) à partir duquel sont chargés le système d'exploitation et les applications. Le système d'exploitation visualise un ensemble de matériel homogène et normalisé quels que soient les composants matériels physiques réels. Les machines virtuelles sont encapsulées dans des fichiers, ce qui permet de les enregistrer, copier et de les provisionner rapidement comme avec vSphere, vCenter et vMotion. Des systèmes complets (systèmes d'exploitation, applications configurées, et matériel virtuel) peuvent être transférés en quelques secondes d'un serveur physique à l'autre pour une maintenance sans interruption de service et une consolidation continue des charges de travail.

Bénéfices;

![]() Le partitionnement

Le partitionnement

Plusieurs applications et systèmes d'exploitation peuvent être pris en charge au sein d'un seul système physique. Les serveurs peuvent être consolidés sous la forme de machines virtuelles sur une architecture de type " scale-up " (pour une évolutivité verticale) ou " scale-out " (pour une évolutivité horizontale). Les ressources informatiques sont traitées comme un pool uniforme pouvant être alloué aux machines virtuelles de manière contrôlée.

![]() L'isolation

L'isolation

Les machines virtuelles sont complètement isolées de la machine hôte et des autres machines virtuelles (certaines failles sont apparues cependant sur VMWare Workstation par le biais d'un contrôle activeX interne permettant l'écriture de fichiers arbitraire. Dans le contexte de l'application l'utilisant (Internet Explorer) et pouvant entraîner un DoS (Deny de Service), d'autres exploitations seraient apparues possibles. Il semble que la virtualisation de serveurs puisse être une solution qui s'impose face aux problèmes de sécurité des réseaux avec la mise en place de honeynet. En revanche, en cas de défaillance ou panne d'une machine virtuelle, les autres machines virtuelles ne sont pas affectées. Aucune perte de données n'est possible sur les machines virtuelles et les applications peuvent uniquement communiquer sur des connexions réseaux configurées pour accepter ou refuser les communications entre certaines machines.

![]() L'encapsulation

L'encapsulation

L'environnement complet d'une machine virtuelle est enregistré dans un seul fichier, ce qui facilite sa sauvegarde, son transfert et sa copie (Snapshot ou instantané). C'est un matériel virtualisé et standardisé qui est présenté à l'application, ce qui garantit la compatibilité.

![]() La Sécurité des Machines Virtuelles

La Sécurité des Machines Virtuelles

Ces technologies sont de plus en plus répandues, VMware mise sur VMsafe. Les solutions compatibles avec ce produit sont en cours de développement chez les éditeurs de logiciels de sécurité. Toutefois, l'éditeur Secure Computing propose déjà des appliances faisant office de passerelles de sécurité virtuelles, notamment Secure Firewall, Secure Web et Secure Mail, basés sur l'interface de programmation de VMsafe. Pour améliorer la sécurité des environnements virtualisés, il faut rappeler aux entreprises l'usage des bonnes pratiques : usage de mots de passe variés pour les Machines virtuelles et adresses IP non séquentielles. Les serveurs et systèmes d'exploitation sur l'hôte doivent aussi être limités au minimum. « Si l'on conserve les mêmes politiques et logiciels de sécurité dans un environnement virtualisé, les risques augmentent. Si un serveur venait à être infectée ou piratée, les conséquences seraient nécessairement plus lourdes que dans le cas de plusieurs serveurs physiques. Certains éditeurs tels que Check Point adapte VPN-1 aux serveurs virtuels VMware.

Un boîtier virtuel pour une sécurité bien réelle. Hyper-V la technologie de virtualisation intégrée à Windows Server 2008 dispose d'un produit crédible pour s'attaquer à la domination de VMware. Reste que l'avance de VMWare dans les grands comptes est telle que les premiers gains de Microsoft sur le secteur devraient d'abord s'opérer sur le marché des PME. Un segment qui sera, sans aucun doute sensible à l'argument de la gratuité. Finalement Microsoft avec Hyper-V Server 2008 distribue l'application gratuitement avec plusieurs solutions de sécurisation...

En simplifiant l'informatique, l'infrastructure virtuelle permet aux entreprises de valoriser leurs ressources informatiques; systèmes, applications et stockage pour une meilleure maîtrise des coûts. Le principe de l'infrastructure virtuelle repose sur la création de ressources moins dépendante de l'infrastructure avec la possibilité de l'étendre au réseau. Les administrateurs peuvent allouer dynamiquement les ressources en fonction des projets les plus demandeurs. La gestion du matériel est désormais totalement indépendante de celle des logiciels et l'équipement matériel peut être traité comme un ensemble unique de ressources à affecter ou à réaffecter "à la volée" sans trop de changements pour les utilisateurs.

Citrix XenServer et XenCenter, VMWare vSphere et vCenter et Microsoft HyperV offrent des produits de virtualisation à grande échelle. Grâce à ces solutions, on peut exploiter le maximum de la puissance des serveurs multiprocesseurs et multicoeurs. Cependant il convient avant tout d'avoir une idée des limites de la bande passante et du stockage, nécessaires pour une solution modulaire et évolutive, valable pour économiser l'énergie et améliorer le retour sur investissements (ROI).

Exemple de produits sur le marché

- Microsoft Hyper-V

- VMware ESX(i) vSphere, vCenter

- Citrix hypervisor, XenServer, XenCenter

VMware ESXi s’installe directement sur le

matériel avec une empreinte faible de 32 Mo. ESXi doit être installé

sur du matériel optimisé pour la virtualisation. La gestion se fait par la DCUI pour Direct Console User Interface, comparable à une interface de configuration et de gestion, bas niveau. VMkernel permet la gestion distante par le biais

d’un ensemble d’API et d’agents.

VMware Server, Workstation, ESXi et ESX: VMware Server est utilisé pour illustrer les techniques

et technologies de virtualisation. Workstation un produit gratuit de VMware est

considéré comme un produit d'appel pour l’introduction à virtualiser de petits environnements,

pour la création d'un Laboratoire ou pour du test en pré production. Son utilité est limitée à des environnements

retreinds en raison des limites de mémoire des machines virtuelles et des

performances disque. VMware Workstation prend en charge plusieurs machines virtuelles, limités comparé

à ESX et ESXi.

VMware ESX: La virtualisation d’entreprise est proposée par les gens qui ont insufflé la vie à l'émulation. VMware ESX et ESX(i) sont des produits qui n’ont pour concurrence que XenCenter et Hyper-V. Les deux produits nécessitent une architecture 64 bits, mais ESXi a des demandes matérielles ou "appliances" plus spécifiques que celles d’ESX. ESXi permet de déployer des machines virtuelles avec leurs applications, d'installer et de travailler avec les outils fournis pour superviser les applications, les convertir et interagir avec vCenter (déploiement vCenter pour Web client).

Introduction à l'équilibrage de charge et cluster sous vSphere

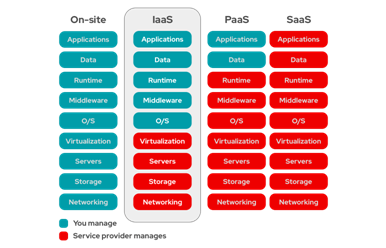

Le Cloud soutient "l'infrastructure"; concernant le réseau, il stocke les bases de données, équilibre et réparti les charges, la gestion des réseaux (des réseaux locaux d'entreprises, aux sites distants; sucursales, entrepôts, etc.) La gestion des données entre sites et les flux de fonctionnement, permet une répartition avec des politiques de sécurité pour des accès sécurisés, soit par site ou par groupe de sites. Une salle de serveurs avec des racks de baies disques permettent d'associer au Cloud ces types de services qui sont généralement au nombre de trois ;

Les services les plus connus:

SaaS, utile lorsque vous avez besoin de redondance et de disponibilité.

PaaS peut être une plate-forme de développement d'applications, Groupware, worflow, application metier dans le Cloud (Public, Privé, Hybride) qui offre plus de flexibilitée.

IaaS permet de bénéficier d'une infrastructure doté de plusieurs serveurs VMWare et Virtual Private Server (VPS) pour "émuler" un environnement complexe avec des Serveurs, des clients et leurs applications, ainsi que des Commutateurs (Switch).

Ainsi, l'entreprise se déleste peu à peu de son infrastructure serveurs et des appliances réseaux. Les mises à jour, la maintenance et la supervision des composants virtualisés (routeurs, commutateurs physiques, politques d'accès, fonctionnalités (Network Fonctionning Virtualisation) deviennent des services comme VMWare et le SDN de Cisco (Software Defined Networking).

Ces deux approches reposent sur la virtualisation du réseau. En revanche, leur manière de séparer les fonctions et de dissocier les ressources diffère. La SDN sépare les fonctions de mise en réseau des fonctions de contrôle du réseau, dans le but de centraliser la gestion et la programmation du réseau. La NFV permet de dissocier les fonctions réseau du matériel. Elle fournit l'infrastructure sur laquelle la SDN s'exécute. En fonction de vos objectifs, vous pouvez associer NFV et SDN sur du matériel standard. Avec ces deux approches, vous pouvez créer une architecture réseau plus flexible et programmable, qui utilise les ressources plus efficacement.

Toutes ces possibilités assurent une redondance matérielle, un équilibrage de charges, une meilleur disponibilité, fléxibilité avec une gestion par logiciel. Pour travailler à distance le "SD-WAN" permet d'accéder à un portail centralisé permettant de bénéficier d'une sécurité accrue. Vous pouvez dans certains cas, relier plusieurs Cloud pour via un socket chiffré de bout en bout. Lorsqu'on parle de DaaS il s'agit toujours d'un environnement virtuel, l'accès s'effectue via un VPN sur un "client léger" ou un canal sécurisé qui permet d'accéder à votre espace de travail, comme çi vous y étiez.

Il semble que les solutions hybrides soient un bon compromis au regard du nombre d'entreprises qui conservent une salle serveurs avec leurs services et leurs composants réseau (routeur et commutateurs).

Cela nous permet d'entrevoir les enjeux futurs et les nouvelles approches du numérique, tant techniques que commerciales. Malgré l'indéniable disponibilité du Cloud avec ses services, l'externalisation des environnements et de leurs applications comportent des "enjeux" importants. Malgré tout ces enjeux, ils peuvent "semble t'il" être critiqués comme l'IA. D'une part, à cause de leurs dépendances en énergie, et d'autre part, à cause des coûts relatifs à leurs mise en oeuvre (PaaS, IaaS, SaaS). Ces coûts sont appliqués par les entreprises prestataires qui fournissent ses services. Mais les calculs des coûts de location doivent être particulièrement suivis et vérifiés pour l'utilisation des services souscrits, le temps d'utilisation, le nombre de Virtual Machines fonctionnelles sur un VPC, etc. Dans le Cloud, le traitement des données et le calcul sont "en théorie" facturés à l’usage.

Lire sur L'usine digitale: Bonnes pratiques pour optimiser vos coûts associés au cloud

Maitrise des vrais coûts du cloud public: Un enjeu important pour les entreprises

Consommation d’un data center :tout ce qu’il faut savoir pour limiter les dépenses

Une entreprise qui souscrit un abonnement auprès d’Amazon (AWS), avec l'exemple de services qui stockent et gèrent vos données personnelles en SaaS ne paie "en principe" que les fonctionalités et la consommation réelle. Un engagement à nuancer... Si vous êtes en quête d'une solutions plus accéssible, vous aurez plutôt intérêt à privilégier les offres de "brokers" moins chers financièrement. L'analyse des coûts avec un Retour sur Investissement avantageux offre plus de souplesse sur une offre SaaS. La facturation des charges, de la bande passante, avec échanges de données réseau, des temps d'utilisation des scripts. Il est donc particulièrement utile de bien comprendre la manière dont sont facturés les servives Cloud.

Le Cloud va pourtant dans le sens de la disponibilité de la pérénité de vos données, c'est un sujet complet, au même titre que la facturation.

En simplifiant la gestion des infrastructures avec la virtualisation, les entreprises peuvent valoriser la disponibilité de leurs ressources, les applications et le stockage pour une meilleure maîtrise des des coûts et une plus grande réactivité. Le principe de l'infrastructure virtuelle repose sur la création de ressources moins dépendantes de l'infrastructure physique axés sur la disponibilitée. Les administrateurs peuvent allouer des ressources dynamiquement en fonction des projets les plus demandeurs en ressources. La gestion matérielle est désormais indépendante de celle logicielle et l'équipement matériel peut être traité comme un ensemble unique de ressources à affecter ou à réaffecter, sans changements ou interruptions pour les utilisateurs finaux.

Le stockage

Depuis les années 90, le prix du stockage a baissé. Aujourd’hui sur des disques durs traditionnels "mécaniques" SATA, en fonction de la marque et surtout de la capacité, le prix se situe entre 2-5 cts d'euros le Go. Pour un disque SATA de marque mais d'occasion, 3To peuvent revenir à 35€. C'est plus cher pour le SCSI plus utile aux entreprises pour le stockage rapide, mais cela met le prix d'un disque dur SATA de 18To à environ de 30€ le Tera. Soit pour un disque Western Digital de 18To, en 3,5 pouces, 6Gb/s de transfert ou bande passante d'interface, 512MB de mémoire EEPROM à 549,38€. Autre exemple pour un particulier, le disque HDD iSCSI, SATA de plus petite capacité comme le Seagate Exos 7E8 en 3.5 pouces de 8To, avec une vitesse de rotation à 7200RPM (rotation per minute), 6Gb/s (transfert ou bande passante d'interface) et 256Mb (mémoire EEPROM) à moins de 200€. En revanche le prix du Gigaoctet pour les disques SSD varie constament. Malgré une hausse des prix qui s'annonce dans l'avenir pour les disques SSD, les baisses des prix bénéficient aux fournisseurs de Cloud et à leurs offres promotionnelles de stockage. Car le Cloud a un coût et celui-çi se chiffre plus en terme de consommation d'énergie qu'en terme de prix du stockage.

Mise en oeuvre de la virtualisation

La popularité de VMware augmente lorsque la Société prend l’engagement "pieux" d’arriver à la neutralité carbone et à une utilisation d’énergie renouvelable à 100% pour ses opérations internationales avant 2020 puis avant 2030. Les objectifs de VMware qui ont été reportés soutiennent la mission de l’entreprise de représenter une force motrice dans le monde et d’apporter à la société, à l’environnement et à l’économie mondiale une contribution supérieure à sa consommation. Citrix lance "XenApp" "XenDesktop", puis l'hypervisor 8.2 avec XenCenter (après l'achat de codes sources de Windows). La société améliore son produit et ses offres de services comme VMware.

Les Machines Virtuelles pour un lab sont "encapsulées" sur des disques. ".VMDK et .VMXF" sont des formats VMWare. ".VDI" est le format utilisé par Oracle. ".VHD" est le format de Microsoft Hyper-V pour les disques limités à 2To et ".VHDX" qui permet de repousser la limite à 64To. Enfin, Oracle Virtual box peut utiliser les formats VHD et VHDX, à l'instar de Citrix XenCenter qui, à la condition que vous bénéficiez du "rôle d’Administrateur de Pool", peut intégrer les formats de Microsoft ".VHD" et de VMware ".VMDK".

Extensions de configuration des Machines virtuelles

Des fichiers binaires qui représentent les disques des VMs, peuvent être dupliqués et manipulés sans limite.

On parle de fabriquer des images, de créer des instantanés (snapshots) etc.

Les extentions les plus connus de VMware sont:

.VMX est un fichier de configuration, .vmxf est un fichier de configuration de VM supplémentaires,

.VMDK correspond au caractéristique du disque virtuel, -flat.vmdk est un disque de données de VM,

.NVRAM correspond à la configuration de mémoire attirbuée via le BIOS ou l'UEFI,

.VMEM est un fichier de sauvegarde de la mémoire paginée,

.VMSD correspond aux paramètres des snapshots,

.VMSN fichier de données des snapshots de VM,

.VSWP est le fichier d'échange ou swap,

.VMSS le fichier d'interruption,

.log le fichier journal,

-#.log vmware-#.log les anciens fichiers journaux.

LA VIRTUALISATION SERVEURS, POSTES CLIENTS ET RESEAUX

L'hyperviseur de type 1 est hébergé sur la couche hardware. Il utilise directement la couche matérielle physique comme un système d'exploitation c'est un hyperviseur natif ou Bare Metal.

L'intégration de la virtualisation sur Windows a commencé à être native à partir de Windows 8-8.1. Avant pour virtualiser un poste client il fallait installer des logiciels de type-2 comme "Virtual PC" ou "Virtual Server". Pour IBM, créateur de la virtualisation cette technologie représentait un processus qui permettrait une utilisation plus efficace du matériel informatique et qui allait poser les bases du cloud computing. L'offre de services d'IBM de virtualisation de partage applicatif le VM/370 crée dans les années 70 voit le jour et permet à plusieurs utilisateurs d'utiliser un système DOS/VSE. Puis VMWare et ses hyperviseurs de type-2 puis 1 transforme la virtualisation et lance son premier logiciel de virtualisation Workstation 1.0 en 1999 suivi d'une offre tous les 2 ans et de l'hyperviseur, ESX Server 1.5 en 2002. En consolidant plusieurs serveurs sur des terminaux physiques, ce produit améliore les performances, simplifie l’administration et permet aux entreprises de réduire leurs coûts de production ainsi que le Return On Investissment (ROI). VMware se taillera une part importante avec des acquisitions et deviendra bientôt un des acteur majeur du marché de la gestion des terminaux mobiles, pour répondre à la demande croissante d’utilisation de terminaux personnels (BYOD) sur le lieu de travail.

Actuellement il existe de nombreux hyperviseurs, comme Oracle Virtual Box, Microsoft Virtual Desktop, VMware Workstation de type 2, ou les hyperviseurs de type 1, Microsoft Hyper-V (intégré à Windows Server 2016 jusqu'à 2022), VMware ESXi-vSphere et vCenter, Fusion pour Mac, Citrix Hypervisor 8.2 CU1 et XenCenter 8.2. Sans compter Linux qui bénéficie d'un grand choix d'émulateurs. Comme KVM intégré en natif sur Linux, Proxmox open source. Linux profite d'un choix de logiciels d'emulation. Déployer des VM ou des serveurs virtuels avec des services, périphériques et composants en tirant partie de la mémoire, de la CPU, des cartes réseaux et du réseau, c'est l'enjeu des hyperviseurs de type 1. VMware par ailleurs propose des pilotes génériques pour faciliter l'installation de nombreuses Machines Virtuelles avec différents systèmes. Le datastore est utilisé par l'hyperviseur pour stocker vos VM, templates (modèles) ou ISO.

Création de packages applicatifs "portables" avec VMware ThinApp

Infrastructure virtualisée ESXi et composants; VM, vMotion et vDS L2.

Migrer une VMachine avec vMotion sur un autre ESXi, sans arrêt de services.

Installation de XenCenter et configuration de XenServer

Hypervisor ESXi. Installation de VM

VMware vSphere 7 : Installation vCenter Server 7.0

LA VIRTUALISATION RESEAU

En 2012 apparaît VMware NSX qui correspond à une plate-forme de virtualisation de réseau destinée au Software-Defined Data Center (SDDC). NSX propose un modèle opérationnel de machines virtuelles pour le réseau dans son ensemble. Associé au Software Defined Network, VMware peut répondre à la demande croissante de l’utilisation de Terminaux Personnels ainsi qu'aux réseaux virtuels.

La popularité de VMware augmente lorsque la Société prend l’engagement (pieux) d’arriver à la neutralité carbone et à une utilisation d’énergie renouvelable à 100 % pour ses opérations internationales d'ici 2030. Les objectifs de VMware soutiennent la mission de l’entreprise de représenter une force motrice dans le monde et d’apporter à la société, à l’environnement et à l’économie mondiale une contribution supérieure à sa consommation. Citrix lance "XenAp" en 2008 avec Xen (Open source mais dont l'utilisation est en berne) et XenServer. Après l'achat des codes sources de Windows, XenCenter avec Citrix hypervisor 8.2 voient le jour. Pendant ce temps, VMware amméliore son produit et ses offres de services.

Principes du SDN

Selon le RFC7149, Le SDN (Software-Defined Networking) est un ensemble de techniques visant à faciliter l’architecture, la livraison et l’opération de services réseaux de manière déterministe, dynamique et pouvant être déployé à grande échelle. L’ONF (Open Networking Foundation, 2013) définit quant à elle le SDN comme étant une architecture qui sépare le plan de contrôle du plan de données, et unifie les plans de contrôle de plusieurs périphériques dans un seul software de contrôle externe appelé " Contrôleur", qui voit le réseau dans sa totalité pour gérer l’infrastructure via des interfaces de communications appelées APIs. Le contrôleur en question fait abstraction de la couche physique pour les applications qui communiquent en langage développeur, permettant la programmation du réseau.

Le réseau est dit SDN lorsqu'on considère 5 caractéristiques :

- Séparation du plan de données et du plan de contrôle.

- Périphériques simplifiés.

- Contrôle centralisé.

- Automatisation du réseau et virtualisation.

- Open source.

Architecture

Le réseau SDN est composé de 3 couches communiquant entre elles par le biais d’interfaces APIs. De la plus basse à la plus haute nous avons :

• La couche infrastructure : Ici se trouve les périphériques qui contiennent les plans

de données du réseau. Autrement dit, les switchs SDN responsables de l’acheminement du trafic.

• La couche contrôle : Elle se base sur le contrôleur SDN, il contrôle le plan de donnée

de façon réactive ou proactive en insérant les différentes politiques de transfert. Cette

partie est le cerveau du réseau et elle englobe la plupart des opérations de calcul.

• La couche application : Héberge les applications qui permettant d’exploiter la

panoplie d’avantages qu’apporte l’architecture, en introduisant de nouvelles fonctionnalités réseaux.

Dans cette disposition l’application communique les décisions et politiques de routage au

contrôleur, qui a son tour traduit ces décisions pour programmer les équipements appropriés.

Les dispositifs de transmission comparent ensuite l’entête des paquets avec les tables de flux

pour ensuite effectuer les actions prédéfinies dans les tables.

L’architecture SDN est donc définie par trois abstractions :

- Transmission : Permet aux applications de programmer et de prendre les décisions concernant le réseau sans pour autant connaitre les détails de l’infrastructure physique. Ceci est achevé à travers l’usage de protocoles ouvert et standardisé pour la communication avec les équipements réseau.

- Distribution : Elle est implémentée par le contrôleur et est essentiellement responsable de deux taches. La première est d’insérer les règles de transfert dans les switchs. La seconde est de récupérer les informations de la couche inférieure, pour informer les applications de l’état de celle-ci, pour pouvoir former une vue globale du réseau.

- Spécification : Permet aux applications d’exprimer le comportement désiré du réseau sans en être directement responsable.

Nous allons par la suite nous intéresser aux spécifications des principaux acteurs de cette architecture.

On s'accorde pour que tous les équipements de transmission SDN sont appelés switch. Dans ce jargon le terme switch est attribué à tout équipement de transmission qui compare l’entête des paquets aux tables de flux, que la comparaison se fasse à base d’adresses MAC (Couche 2), d’adresses IP (Couche 3) ou une combinaison de plusieurs champs. La terminologie de switch a été adoptée en référence à l’unique tache de ces équipements qui est la transmission.

Un switch SDN est composé d’une API qui permet de communiquer avec le contrôleur, une couche d’abstraction qui consiste en un pipeline de tables de flux et une fonction de traitement de paquets.

fonctionnalités du SDN

Les tables de flux sont un élément fondamental du fonctionnement de switch SDN, elles sont composées d’un nombre d’entrées de flux, lesquelles consistent en deux composantes principales :

- Champs de correspondance : Ils sont utilisés par ordre de priorités pour être comparés aux entêtes des paquets entrants, le premier champ correspondant est directement sélectionné.

- Les Actions : Ce sont les instructions qui doivent être exécutés si une correspondance

entre un paquet entrant et l’entrée pour laquelle ces actions sont spécifiées. La logique du traitement de paquets consiste en un nombre de mécanismes qui se mettent en actions en fonction du résultat de l’évaluation de l’entête du paquet et la correspondance de priorité la plus haute. Lorsqu’une correspondance est trouvée, le paquet est traité localement dans le switch, à moins qu’il soit explicitement envoyé au contrôleur. Si aucune correspondance n’est trouvée, une copie du paquet est envoyée au contrôleur qui devra décider quoi en faire, et éventuellement mettre à jour la table de flux pour l’y introduire comme entrée.

On distingue 2 types de switchs SDN :

• Le switch SDN logiciel ou virtuel est le moyen le plus simple pour créer un équipement SDN. Ce modèle est plus lent et moins efficace car il ne bénéficie pas d’une accélération hardware, mais présente l’avantage d’être plus flexible, plus riche dans les actions disponibles, et supporte un nombre d’entrées beaucoup plus important. Les switchs logiciels sont très présents dans les environnements virtuels et sont généralement open source.

• Le switch SDN matériel sur lequel on peut ajouter un switch virtuel : implémentation rapides pour un environnement très haut débit (100Gbs) étant sensible aux performances. Pour transcrire les différentes entrées de flux et leur composantes dans les switchs on a opté pour l’utilisation de hardware spécialisé, pour le traitement de couche 2 (MAC) on utilise les CAMs (Content-Addressable Memories) et pour la couche 3 les TCAMs (Ternary Content-addressable Memories). Ces switchs sont adaptés aux data center et au cœur du réseau, les politique de flux n’y sont pas centrés sur les utilisateurs ce qui fait que le nombre d’entrée y est moins important que dans les switchs qui sont plus prés de l’accès.

Le contrôleur

Le rôle du plan de contrôle est de contrôler et de gérer les équipements de l’infrastructure et de les relier avec les applications. Il est composé d’un ou de plusieurs contrôleurs et est considéré comme système d’exploitation du réseau. Les premières versions du SDN présentaient un plan de contrôle composé d’un seul contrôleur centralisé. Par la suite des architectures distribuées utilisant plusieurs contrôleurs ont été proposées pour améliorer les performances et la scalabilité du réseau (facultés d'un logiciel ou d'une application à s'adapter aux fluctuations de la demande, tout en conservant ses fonctionnalités de base). Les performances des contrôleurs SDN sont caractérisées par le débit par seconde et la latence, qui est le temps d’installation d’une nouvelle règle.

Afin de pouvoir interagir avec le réseau, le contrôleur a besoin d’une vue précise de ce dernier. la base NIB (Network Information Base) est déterminante. Cette NIB est construite au niveau du contrôleur et permet à ce dernier de savoir comment implémenter chaque ordre abstrait, trouver les équipements qui doivent être reconfigurés, s’assurer de la capacité de ces derniers à implémenter une directive avec les API supportées par l’équipement.

Le Software-Defined Data Center

le SDDC propose un modèle opérationnel de machines virtuelles pour le réseau dans son ensemble. Associé au Software Defined Network, une ou plusieurs cartes physiques et virtuelles par hyperviseur, elles permettront de créer un périphérique virtuel avec un noeud reliées à un commutateur physique. Lorsque vous créez un SD-WAN il est géré par le contrôleur. Il deviendra possible via l'interface centralisée comme vCenter d'administrer les environnements vSphere, voir d'ajouter à la topologie des VLANs avec les protocoles STP, RSTP, PVST+ pour consolider en continu, l'équilibrage de la charge réseau et le filtrage du broadcast. La disponibilité et la sécurité de l'infrastructure est renforcée. La virtualisation des serveurs associée à l'offre des services multi-cloud permettent de créer des infrastructures de gestion centralisées et d'émuler les topologies réseaux pour contrôler le transfert des flux de données pour les environnements complexes entre les composants et "periphériques" réseaux. Vous pouvez gérer votre réseau, allouer de la bande passante, répartir et équilibrer les charges, relier vos sites distants, créer un noeud de secours, assurer vos sauvegardes ou faire face à un arrêt de services avec la redondance et restaurer votre environnement à chaud. Les liens vers un fournisseur de service Internet (ISP) et l'interface de gestion permettent de béneficier de plusieurs fonctionnalités ; l'accès aux services réseau avec SDN, l'accés à vos sites et succursales distantes. NSX+, propose une nouvelle offre SaaS pour la gestion et le déploiement de services de réseau, de sécurité et d’équilibrage de charge avancé. Depuis plus de 15 ans et l'apparition de la technologie NSX, SDN et SD-WAN, il ne s'agit plus d'innovation, mais d'une métamorphose du secteur des réseaux et télécommunications.

Infrastructure en cluster pour ESX, vCenter, vMotion et vDS "vSphere Distribute Switch".

La virtualisation des fonctionnalités réseaux avec NFV ou Network Fonctionnig Virtualisation désigne le remplacement des "appliances réseaux" ou matériels réseaux par des composants virtuels qui exécutent les processus sous le contrôle de l'hyperviseur ESX. Le Software Defined Networking ou SDN de Cisco est un réseau défini par logiciel qui consiste à séparer la couche de gestion des flux de la couche des données transmisent sur le réseau. L'objectif de cette dissociation est de créer un réseau centralisé et programmable. Cette "couche" utilise des composants et plateformes virtuelles de gestion.

Cette couche utilise une formule logicielle pour le multi-Cloud VMware NSX afin d'assurer la sécurité des transferts de flux entre vos sites locaux et distants, que vous pouvez répartir entre plusieurs fournisseurs.

la virtualisation du réseau (NV ou Virtual Network), Network functions virtualization (NFV) et Réseau Défini par Logiciel (SDN) ou Software Defined Network.

Les approches (SDN, NFV, NV) reposent sur la virtualisation et l'abstraction du réseau. En revanche, leurs manières de séparer les fonctions et de dissocier les ressources diffèrent. SDN sépare les fonctions de mise en réseau des fonctions de contrôle du réseau, dans le but de centraliser la gestion et la programmation du réseau. NFV permet de dissocier les fonctions réseau du matériel. Elle fournit l'infrastructure sur laquelle la SDN s'exécute. La "Fabrique Ethernet" sous entend des réseaux soumis à la technologie Ethernet, composé d'un ensemble de câbles de catégories récente, d'un routeur et d'un ou plusieurs switchs en fonction de vos objectifs. Vous pouvez associer NFV et SDN sur du matériel standard. Avec ces deux approches, vous pourrez créer une architecture réseau flexible, programmable, redondante et sécuirisé pour gérer plus éfficacement les ressources de manière centralisée.

SDN Part-1

SDN Part-2

Le SD-WAN permet à l'aide d'une interface GUI d'équilibrer les charges réseau, de créer des jobs de sauvegarde en planifiant les tâches au moment ou le réseau est le moins sollicité ou d'utiliser une "patte" dédiée à l'aide de votre serveur de management (contrôler-Pare-feu). Ce contrôleur permet de basculer les accès aux sites distants, de monitorer des tâches de supervision, de sécurité ou de sauvegarder en sélectionnant au choix, l'accès au FAI réseau dont dépendera le niveau de débit (ex: 1Gbps et 100Mbs) tout en préservant la sécurité avec votre pare-feu "FortiGate, ASA, Palo alto", etc.. Cela afin d'assurer une redondance d'accès, ou en cas d'arrêt du service, de basculer d'un Fournisseur à l'autre. Cela vous permettra de "dispatcher" les besoins en bande passante en fonction de la demande à l'aide du GUI (Graphical User Interface) contrairement au CLI (Command Line Interface). L'utilisation d'un agent ou comme c'est le cas actuellement d'un interface basée sur une API permet de gérer le réseau et ses composants VM et VPS vSphere, vCenter via le contrôleur.

Comment gérer et configurer les interfaces réseaux sur ESXi

Agent ou API (Application programming interface) et interface applicative

SD WAN fournit une sélection de raccordements possibles programables couplés à la sécurité ssh et pare-feux.

La mise en œuvre d'un SD-WAN comprend :

• La gestion centralisée de la configuration

• La créaton et la gestion "automatique" de la topologie réseau, des droits et des accès

• Répartition du trafic

• Supervision via l'interface centralisée.

Réseau virtuel et Software Defined Network

VMWare et réseau virtuel

Gestion configuration des interfaces réseau sur ESXi

vSwitch et vSphere 6.7

Voir sur SD-Access et DNA Center de Cisco

L'approche matérielle et logicielle intégré (Cisco ACI) permet d'être utilisée dans les datacenters pour les clients qui veulent des solutions réseaux plus flexibles et plus facilement securisées que des architectures réseaux traditionnelles. Le SDN peut également se décliner en sous-catégories, LAN pour Réseau local comme le réseau étendu WAN (Wide Area Network) défini par logiciel. Le SDN avec d'autres approches telles que NFV ou NSX peuvent également servir à segmenter et accroître la sécurité.

NSX+

Déployer le loadbalancer F5 sur AWS en utilisant Terraform et VAULT avec un compte créé via les polices de sécurité

Manager Vault avec Terraform

AWS automation avec Ansible en 3 parties (part1)

Introduction à Ansible

Avec la virtualisation des systèmes et applications pour terminaux mobiles et les services Cloud: Software as a Service, Platform as a Service, Infrastructure as a Service vous pouvez bénéficier de possibilités bien plus étendues. L'intêret de la virtualisation et du Cloud sont largement développé sur Internet. Nous pouvons citer; le stockage, la gestion des services, la redondance de l'architecture, l'accès au socle applicatif; Middleware, groupware, partages. Pour l'exemple, nous utilisons chaque jour avec notre smartphone le SaaS pour la sécurité et le FRP (Factory Reset Protection) lié à votre ID d'utilisateur Google. Factory Reset Protection (FRP) est une fonction de sécurité des appareils Android qui empêche l'utilisation de l'appareil si ses paramètres d'usine sont restaurés sans autorisation Google. Comme pour le VDI qui assure un déport d'affichage avec un module web ou un agent qui permettent d'utiliser une connexion sécurisé avec Certificat (éventuellement chiffré via un VPN). Vous pouvez travailler comme çi vous étiez au bureau à la condition d'utiliser votre ID et mdp de session et en complément, l'identifiants de la connexion VPN sécurisée. La concurrence ne manque pas dans ce domaine. La plupart des utilisateurs de VDI ont recours à HDX de Citrix, au protocole RDP, RemoteFX de Microsoft ou VMware Blast Extreme ou encore PCoIP.

Une entreprise qui souscrit un abonnement via WMWare auprès d’Amazon (AWS), avec l'exemple de services qui stockent et gèrent vos données personnelles en SaaS, ne paie "en principe" que les fonctionalités et la consommation réelle. Un engagement qui doit être nuancé... Si vous êtes en quête d'une solutions plus accéssible, vous aurez plutôt intérêt à privilégier les offres de "brokers" financièrement plus intessantes. L'analyse des coûts avec un Retour sur Investissement avantageux offre plus de souplesse sur une offre SaaS.

En revanche,

la facturation de IaaS ou de Paas pour la virtualisation et la gestion de VPS, VM, stockage, avec la charge des processeurs, des temps d'utilisation des scripts d'automatisation, ou les échanges et la duplication des données réseaux, imposent de bien comprendre la manière dont sont facturés les servives Cloud.

Les offres plus anciennes comme celle de "Palo Alto" ou VMware propose le SD-WAN avec l'accès à une interface permettant de bénéficier d'un tableau de bord pour vérifier la santé des terminaux, les applications, le réseaux et ses politiques de sécurité. Grâce à cette interface et aux possibilités qu'elle offre sur le réseau, les administrateurs peuvent isoler les problèmes rapidement pour par exemple des solutions de gestion de services IT (IT Service Management ou ITSM) afin d'automatiser le processus de gestion des incidents de bout en bout et de la CMDB.

Il est donc particulièrement utile de bien comprendre la manière dont fonctionnent et dont sont facturés les services Cloud. Vous devez respecter les codes de bonnes pratiques et quant à votre fournisseur, il s'engage contractuellement à respecter le RGPD. Il semble, malgré les efforts faits dans ce sens que certains aspects que proposent les hébergeurs de Cloud ne soient pas encore totalement établis tant la répartition des données est sensible. Lorsque par exemple, votre espace de stockage se trouve à l'étranger. Vous devez à ce titre, localiser vos données au plus près de votre situation géographique et votre fournisseur de Cloud doit vous assurer que les données personnelles de l'entreprise ne seront pas dupliquées vers un autre continent. Cela concerne en particulier le Cloud hybride, le plus utilisé pour son accessibilité, la duplication et la sécurité des données. Pour limiter les risques juridiques, le choix de la géocalisation doit être correctement définit car celui-çi repose, sur la disponibilité des données de l'entreprise et de l’utilisateur. Parfois, ces données qui peuvent être stockées chez un fournisseur de Cloud transitent par un sous-traitant, pour des raisons de coûts. Si l'infrastructure de stockage est dupliquée pour causes géographique, il conviendra de bien prendre en compte les enjeux juridiques de vos choix, pour les raisons mentionnées. Si vos moyens sont limités, préférez un fournisseur de Cloud hybride situé dans l'espace Européen.

Mieux comprendre la métamorphose actuelle et les enjeux futurs du numérique.

Plus sécurisé, basé sur des connexions privés virtuelles chiffrées, la mise en oeuvre du SD-WAN avec VLAN dans des centres de collocation permet au personnel de succursales d'accéder en toute transparence et en toute sécurité aux applications et aux données qui résident sur le Cloud AWS, Azure, Google, etc. Les Sociétés se tournent vers ces nouvelles solutions pour continuer à répondre aux exigences imposés par les avancés technologiques et optimiser le retour sur investissement. Le marché du SD-WAN plus facile à aborder que MPLS, simplifie la vision et la gestion de votre réseau pour mieux s'adapter à vos besoins et aux attentes de vos clients. Que vous soyez une Entreprise internationale, une PME ou TPE ou une association différentes solutions s'offrent à vous.

LA CONSOMMATION D'ENERGIE ET LE NUMERIQUE

Une étude de l'Union française de l'électricité (UFE), montrait que la consommation des Centres de Données s'élevait à environ 3TWh en 2015... Soit l'équivalent de la consommation électrique d'une ville comme Lyon. D'ici 2021, la capacité de stockage des centres de données devrait être multipliée par 4, selon une Étude de Cisco. Un centre de données "hyperscale" (plusieurs centaines de m² d'armoires avec des baies rackés, constituées de LUN pour le stockage, reliés physiquement à des Hyperviseurs qui hébergent des systèmes et réseaux virtuels pour optimiser au maximum l'espace), devrait doubler en moins de 6 ans. Fin 2016 il y avait 338 Datacenter pour 628 en 2021. Mais cela correspond seulement à 53% du nombre total des centres de données. Nous sommes tous concernés par ce problème d'énergie qui va augmentant, même s'il reste difficile à concrétiser pour le commun des mortels. Lire sur le site "fournisseur-energie.com", comment réduire la pollution numérique. Cela vous permettra de comprendre les enjeux avec une nouvelle approche du numérique et l'indéniable disponibilité du Cloud; "Software as a Service", "Platform as a Service", "Infrastructure as a Service", "Desktop as a Service". Les Middleware et dans une moindre mesure la "déportation de l'affichage" du DaaS (Desktop as a Service) et du VDI (Virtual Desktop Interface), sont critiqués à cause de leurs dépendances en énergie et de leurs coûts fixes, car on associe trop souvent le Cloud à des engagements de baisse des coûts...

la consommation d'environ 5 serveurs en baie "standards" est d'environ 3.350 watts. La consommation est largement plus basse avec la virtualisation et le Virtual desktop. La consommation électrique est étroitement liée au refroidissement et à la circulation de l’air. La virtualisation réduit le nombre d’alimentations, de processeurs (multi-coeurs) et de disques (la technologie RAID est indispensable même s'elle n'est plus toute jeune). Tous ces éléments génèrent et dissipent une quantité significative de chaleur. En diminuant le nombre d’éléments dégageant de la chaleur, vous diminuez également la puissance nécessaire pour refroidir éfficacement et maintenir à de 18° la température d'une salle serveurs. En effet, pour virtualiser un serveur, il faut compter 1 coeur processeur puissant par "machine virtuelle" avec entre 4 et 6 Go de mémoire vive...Pour un serveur plus gourmand 4 coeurs et 8 Go de RAM au minima seront nécessaire. Ce qui est bien différent en fonction des fonctionnalités du serveur, par exemple un proxy ou un pare-feu même doté d'une swap conséquente. Les éléments qui seront toujours privilégiés sont la puissance du(es) processeurs, le nombre de coeurs par processeur(s), et la RAM (mémoire vive).

Des réponses aux besoins en constante évolution

Avec un suivi approfondi il est possible de limiter les incidents et d'approcher le "zéro interruption de services". Associés aux centres de données ou aux fermes de serveurs (datacenter), à la redondance, à l'équilibrage, il devient possible d'optimiser la disponibilitée, même pour les services les plus exposés. L'évolution des disques iSCSI, SATA, SSD et des connexions de plus en plus rapides du type iSCSI, Giga ethernet, fibre, les instantanés éffectués à partir d'un système (à un instant "T") sont plus faciles à exécuter. Le processus d'équilibrage et la répartition des charges système et réseau devient plus souple. Comme la volumétrie du stockage. Les PRA (Plan de Reprise d'Activité) ne représentent plus un défi comme autrefois. Cependant, aucune structure n'est totalement à l'abri d'une défaillance serveur... A moins de bénéficier d'une infrastructure virtualisée avec tolérance de pannes, équilibrage et répartition des charges systèmes (vSphere vMotion) pour basculer d'une unité à une autre en un temps records.

Le Cloud avec les évolutions des services; applications déportées, accès à distance sécurisés, Virtual Private Server, Virtual machine, hyperviseurs facilitent et simplifient les tâches. Il devient possible dans la mesure ou la sécurité est respectée, de partager le travail à l'aide d'un serveur web Apache gratuit ou le serveur Web Microsoft IIS sur lesquels vous aurez implémenté un Groupware Microsoft SharePoint permettra de mettre à disposition aux utilisateurs une plateforme applicative (Middleware) avec Office 360 sur un cloud via une connexion Internet spécifique via un VPN. Vous pourrez aussi travailler à distance sur une interface virtuelle, via un serveur déporté et le VDI (Virtual Desktop Interface) qui vous "enverra" via un profil itinérant votre bureau avec ses applications. Lorsque vous ouvrirez Word ou toutes autres applications, vous le ferez à partir VM sur un serveur virtuel distant et le résultat de vos modifications se feront directement sur le serveur qui "hébergera" votre interface virtuel.

GED dans le cloud: collaboration, workflow et gouvernance des données, signature électronique et sécurité.

CONFINEMENT ET TELETRAVAIL

L'utilisation de systèmes centralisés sur Windows pour travailler à distance a commencé sous Terminal Server qui communiquait avec le client via les protocoles d'accès à distance, RDP ou via un "agent" comme Citrix qui disposait de l'agent ICA. La compression des données permettait d'accéder facilement à l'interface "déportée" sans utiliser d'un tunnel sécurisé. Afin de créer un tunnel sécurisé, un VPN était indispensable et de nombreuses solutions comme PCAnyware, UltraVNC, GoToMyPC, etc. étaient utilisés. Ses solutions ne permettaient pas de filtrer les accès et des solutions sont apparuent sécurisées comme Citrix Netscaler Gateway 12.0 qui prend en charge le protocole PCoIP, qui est le protocole d’affichage à distance de plusieurs solutions d'autres éditeurs de VDI, comme VMware Horizon View. PCoIP est analogue au protocole Citrix HDX/ICA et au protocole Microsoft RDP.

Alors que de plus en plus d'employés demandent l'opportunité d'effectuer une partie ou la totalité de leur travail à distance, les organisations ont de plus en plus besoin de directives clairement définies régissant les attentes et les responsabilités des employés et de l'entreprise. Cette politique décrit les processus de l'organisation pour demander, obtenir, utiliser ou mettre fin à l'accès réseaux afin de permettre aux membres du personnel de travailler régulièrement à distance sur une base formelle.

La technologie actuelle permet aux entreprises d'offrir aux employés la possibilité de travailler à domicile, sur la route ou à peu près n'importe où en dehors du siège social. Cela peut profiter à la fois à l'employé et à l'entreprise de diverses manières. Mais comme de plus en plus d'employés demandent le télétravail, les entreprises doivent avoir une politique de télétravail viable.

Objectifs: Le but de cette politique est d'établir des lignes directrices pour les employés qui souhaitent participer au programme de télétravail de l'organisation.

Rémunération, heures de travail et admissibilité: La rémunération, les avantages sociaux, le statut de travail et les responsabilités professionnelles de l'employé ne changeront pas en raison de sa participation au programme de télétravail. Le temps que l'employé est censé travailler par jour et le temps ainsi que la méthode de paiement ne changera pas en raison de sa participation au programme. Les employés sont sélectionnés en fonction de la pertinence de leur emploi, d'une évaluation et probabilité qu'ils réussissent à travailler à distance avec l'approbation d'un superviseur. Chaque département prend ses propres décisions en matière de télétravail et pourra mesurer les résultats. Mais avant le télétravail, les employés doivent lire et signer un accord sur leur politique de télétravail. Le service informatique ne peut prendre en charge aucun télétravailleur qui n'a pas retourné un formulaire d'accusé de réception de politique de télétravail signé à la fois par l'employé et le responsable de l'employé.

Équipements: L'entreprise peut fournir des outils et de l'équipement aux employés pour qu'ils s'acquittent de leurs responsabilités professionnelles à distance. L'équipement peut inclure du matériel informatique, des smartphones, des tablettes, des logiciels de connexion privée comme un VPN d'entreprise, voir une clé USB d'authentification aléatoire, une boite pour courriels sécurisée avec certificat, une connectivité aux applications hôtes, un portail d'échange avec le support et d'autres ressources applicables jugées nécessaires. L'utilisation de ces ressources, fournies par l'entreprise pour une utilisation distante, doit resté limitée aux personnes autorisées et pour l'entreprise uniquement. Selon la nature du travail, les employés du télétravail peuvent utiliser leur propre équipement mais avec une connexion dédiée et mise en oeuvre par l'entreprise (RDP et VPN). Les employés sont responsables de l'installation, de la réparation et de l'entretien de tout l'équipement personnel utilisé pour le télétravail mais ils doivent également comprendre et accepter que l'entreprise puisse accéder à des fins professionnelles à tout équipement personnel utilisé pour le télétravail.

Lorsque vous êtes connectés à Chrome, ne vous laissez pas tenter en enregistrant vos mots de passe Google sur des sites marchands (informations d'authentification). Evitez de croiser les authentifications comme par exemple utiliser l'indentifiant et le mot de passe de Google pour vous connecter à Facebook, Amazon, Ebay, Cdiscount, etc. Heetch demande quant à lui à être relié à votre compte Facebook... Sur un smartphone avec un compte gmail tous vos mots de passe et contacts seront sauvegardés sur le cloud de Google, "Drive". Avec d'autres fournisseurs vous risquez d'être sollicité par de nombreux appels téléphonique pour vous faire la démonstration que sur certains produits vous pourrez bénéficier d'avantages subtantiels et faire des économies.

Si vous voulez savoir d'ou viennent ces numéros, voir leurs capacités de nuisances, un site peut être utile: numeroinconnu.fr

Cela représentait des investissements conséquents pour se connecter à un serveur centralisé afin d'accéder à des applications déportées pour le VDI (Virtual Desktop Interface). Avec la couche Hardware qui intègre maintenant des puces AMD, INTEL, avec un couche dédiée à la virtualisation, des logiciels de collaboration de contenus, de Virtual Desktop Interface se trouvent à portée de clic. Vous travaillez sur les serveurs de l'entreprises. Peu importe votre localisation, les applications sur lesquelles vous travaillez sont situés en réalité dans un datacenter.

Un autre aspect, la création des packages applicatif .MSI ou Mode Portable. Pour faciliter les déploiements applicatifs, voir envoyer directement sans installation pour une utilisation "sans dépendances" avec le système...

les serveurs vous proposent des applications qui fonctionnent comme du "streaming" de données sur poste de travail avec profils itinérants.

Lire sur Microsoft les spécificités d'un profil itinérant ou roaming profil.

Sur les sujets:

Etudier en ligne la certification réseau Cisco CCNA 200-301

Tarification SD-WAN, analyse des coûts, liste de prix et retour sur investissement (ROI)

Numérique et écologie : les datacenters sont-ils des gouffres énergétiques ?

Directive 2009-125-CE du Parlement Européen et du Conseil du 21 octobre 2009 établissant un cadre pour la fixation d’exigences en matière d’écoconception applicables aux produits liés à l’énergie

Microsoft Technet: l'optimisation d'infrastructures

Lire "les enjeux technologiques de l'information et de la communication"

Capacité d'optimisation d'infrastructure: processus de gestion ITIL/COBIT

Centre de services et résolution des incidents sur site (ITSM)

Virtualisation de l'infrastructure des postes de travail

Virtualisation d'infrastructure de postes de travail (VDI); enjeux des DSI

CLIENTS LEGERS ET VIRTUAL DESKTOP INTERFACE

Voir la page Serveur Citrix

![]() Les solutions de virtualisation des applications permettent "de delivrer" des applications afin quelles soient disponibles aux postes clients qui bénéficient d'un agent. L'agent Citrix (Virtual delivery agent) et XenDesktop VdaSetup agissent en déportant l'interface graphique de votre poste ou bureau sur le poste client. On utilise l'agent soit, copié locallement ou comme bureau distant (Terminal services). Les applications sont séparées des postes qui accèdent aux serveurs d'applications regroupés en ferme. Cela permet une meilleure adaptabilitée. Du point de vue de l'utilisateur les applications paraîssent être installées localement. Hier, organisé autour d'un lieu fixe, le salarié utilisait principalement le téléphone et le PC comme outils de travail. Désormais de plus en plus de structures utilisent l'usage de terminaux connectés en situation de mobilité, tels que les tablettes ou les smartphones. Pour autant, l'utilisateur a besoin de retrouver sur ces nouveaux terminaux son environnement de travail habituel, les applications de son entreprise et ses données, qu'il soit au bureau, à son domicile, ou en déplacement. Et cela indépendamment de l'objet connecté qu'il utilise. C'est là qu'intervient la Virtualisation de poste de travail, l'infrastructure IT qui permet la virtualisation du poste de travail. Utilisant des serveurs situés dans l'entreprise, voire dans un data center dans un Cloud.

La VDI permet d'implémenter une machine virtuelle (VM) sur laquelle s'exécutent l'environnement de travail et les applications de l'utilisateur. Ainsi l'utilisateur accède à son poste de travail virtuel en affichant le contenu de la VM sur son terminal.

Les solutions de virtualisation des applications permettent "de delivrer" des applications afin quelles soient disponibles aux postes clients qui bénéficient d'un agent. L'agent Citrix (Virtual delivery agent) et XenDesktop VdaSetup agissent en déportant l'interface graphique de votre poste ou bureau sur le poste client. On utilise l'agent soit, copié locallement ou comme bureau distant (Terminal services). Les applications sont séparées des postes qui accèdent aux serveurs d'applications regroupés en ferme. Cela permet une meilleure adaptabilitée. Du point de vue de l'utilisateur les applications paraîssent être installées localement. Hier, organisé autour d'un lieu fixe, le salarié utilisait principalement le téléphone et le PC comme outils de travail. Désormais de plus en plus de structures utilisent l'usage de terminaux connectés en situation de mobilité, tels que les tablettes ou les smartphones. Pour autant, l'utilisateur a besoin de retrouver sur ces nouveaux terminaux son environnement de travail habituel, les applications de son entreprise et ses données, qu'il soit au bureau, à son domicile, ou en déplacement. Et cela indépendamment de l'objet connecté qu'il utilise. C'est là qu'intervient la Virtualisation de poste de travail, l'infrastructure IT qui permet la virtualisation du poste de travail. Utilisant des serveurs situés dans l'entreprise, voire dans un data center dans un Cloud.

La VDI permet d'implémenter une machine virtuelle (VM) sur laquelle s'exécutent l'environnement de travail et les applications de l'utilisateur. Ainsi l'utilisateur accède à son poste de travail virtuel en affichant le contenu de la VM sur son terminal.

Les solutions serveurs d'applications avec clients légers permettent de faire des économies avec une réduction des coûts en postes clients. Les coûts induits de distribution et de maintenance ne sont plus aussi importants et prolongent la durée de vie du parc. La mobilité est aussi abordée pour les utilisateurs qui accèdent de n'importe quel endroit à leurs applications et à leurs données de manière transparente, sécurisée et sur n'importe quels périphériques. On associe aux applications hébergées sur serveurs d'applications (Server-side) la virtualisation d'applications "streamées" (Client-side). En termes de sécurité des solutions d'authentification renforcées s'effectuent par téléchargement de certificats signés. Les postes bénéficient d'un agent peu gourmand en bande passante et les applications d'une compression logicielle très éfficace.

Le maintien des performances serveurs et réseau est une constante. Cela implique une gestion optimale de la répartition des charges. Assurer la publication des applications nécessite une bonne supervision. Etablie en temps réel la supervision est abordée avec la création de statistiques extensibles. Les accès (usages utilisateurs, applications exécutées, consommation des ressources, etc.) peuvent être auditées à l'aide d'outils (natifs ou tiers) et des mesures de qualité de services. C'est le cas pour XenApp avec EdgeSight. XenApp est une solution complète pour toutes les applications publiées ou delivrées accessibles de manière centralisées ou déportées sur les périphériques des utilisateurs finaux, tels que smartphones (end user devices). XenApp procure un service de bout en bout (end-to-end) afin de faciliter l'administration d'infrastructures et la gestion des applications utilisateurs.

![]() Dans les domaines de la virtualisation et des postes de travail, il existe actuellement plusieurs technologies : la virtualisation applicative, telle qu'elle est traitée par Citrix avec XenApp ou VMware Horizon (plate-forme d’infrastructure de postes de travails virtuels (VDI) qui fournit des postes de travail et des applications virtualisés accessibles à distance). La virtualisation du poste de travail peut être exécutée totalement ou en partie sur des plate-formes serveurs accessibles depuis le réseau aux clients par protocoles de déport d'affichage.

Dans les domaines de la virtualisation et des postes de travail, il existe actuellement plusieurs technologies : la virtualisation applicative, telle qu'elle est traitée par Citrix avec XenApp ou VMware Horizon (plate-forme d’infrastructure de postes de travails virtuels (VDI) qui fournit des postes de travail et des applications virtualisés accessibles à distance). La virtualisation du poste de travail peut être exécutée totalement ou en partie sur des plate-formes serveurs accessibles depuis le réseau aux clients par protocoles de déport d'affichage.

![]() La Virtualisation de poste de travail (VDI) offre aux utilisateurs finaux un PC virtuel qui ressemble à leur PC actuel et se comporte exactement de la même manière, qu'ils travaillent au bureau, en déplacement ou de chez eux. En fonction de la localisation ces paramètres de sécurité changent et il est important de bien prendre en compte la sécurité des transactions. Les fichiers et profils des utilisateurs sont stockés de manière centralisé (sur des serveurs dédiés à cet effet). Les usagers ne perdent pas de temps à les rechercher puisque les applications sont accessiblent à distance directement à partir de leur bureau. Citrix AppSense et XenDesktop ou VMWare VSphere View ou actuellement Horizon avec View proposent des solutions de virtualisation des postes de travail sécurisées pour LAN ou WAN.Avec XenDesktop 5 La simplification de l’installation et du dimensionnement de l’environnement

a été rendue possible par des modifications de l’architecture. Jusqu’à la version XenDesktop 4 incluse, le produit se basait

sur la structure de gestion de batteries IMA (Independent Management Architecture),

présente dans MetaFrame XP / Presentation Server/XenApp et s’appuyant sur

la négociation des connexions Active Directory entre les postes de travail et les

gestionnaires de connexion. La version 5 de XenDesktop, quant à elle, utilise une

architecture de sites s’appuyant sur une base de données Microsoft SQL Server.

La Virtualisation de poste de travail (VDI) offre aux utilisateurs finaux un PC virtuel qui ressemble à leur PC actuel et se comporte exactement de la même manière, qu'ils travaillent au bureau, en déplacement ou de chez eux. En fonction de la localisation ces paramètres de sécurité changent et il est important de bien prendre en compte la sécurité des transactions. Les fichiers et profils des utilisateurs sont stockés de manière centralisé (sur des serveurs dédiés à cet effet). Les usagers ne perdent pas de temps à les rechercher puisque les applications sont accessiblent à distance directement à partir de leur bureau. Citrix AppSense et XenDesktop ou VMWare VSphere View ou actuellement Horizon avec View proposent des solutions de virtualisation des postes de travail sécurisées pour LAN ou WAN.Avec XenDesktop 5 La simplification de l’installation et du dimensionnement de l’environnement

a été rendue possible par des modifications de l’architecture. Jusqu’à la version XenDesktop 4 incluse, le produit se basait

sur la structure de gestion de batteries IMA (Independent Management Architecture),

présente dans MetaFrame XP / Presentation Server/XenApp et s’appuyant sur

la négociation des connexions Active Directory entre les postes de travail et les

gestionnaires de connexion. La version 5 de XenDesktop, quant à elle, utilise une

architecture de sites s’appuyant sur une base de données Microsoft SQL Server.

La Virtualisation de Desktops (VDI) fait entrer la virtualisation dans l'environnement des postes de travail, offrant ainsi une facilité de gestion et un contrôle, tout en maintenant un environnement convivial pour les utilisateurs. La VDI virtualise les images qui peuvent être déployées à partir d'un serveur d'hébergement centralisé. Les coûts d'exploitation sont réduits et la sécurité améliorée, alors que l'expérience des utilisateurs finaux restent identique. La technologie VDI offre de véritables avantages avec :

- Une meilleur rentabilité

- Une solution écologique

- Une meilleure Facilité de gestion

La VDI permet de consolider le nombre de serveurs prenant en charge les interfaces des bureaux d'où des économies en termes de coûts. D'autres économies sont issues de la gestion centralisée, du déploiement des applications et des mises à jour, qui rendent ainsi inutile les déplacements routiniers vers le bureau des utilisateurs à cause d'erreurs. Permettant ainsi d'améliorer l'expérience HelpDesk.

![]() Les solutions de virtualisation des postes de travail

Les solutions de virtualisation des postes de travail

Citrix et Intel se sont associés pour développer un hyperviseur léger embarqué dans un poste de travail. Un hyperviseur bare-metal avec une base Xen dans les processeurs ; Intel doté des technologies VT et AMD-V. Ce nouvel hyperviseur permet de diffuser directement sur une machine virtuelle cliente isolée, de façon dynamique un poste de travail géré de manière centralisé avec toutes ses applications. La solution met en cache et exécute le poste de travail et les applications directement sur le PC client, par déport d'affichage garantissant ainsi des performances élevées, une richesse graphique et une mobilité complète pour les utilisateurs d'ordinateur portable.

XenServer, et applications pour Desktop services

VMware Horizon 8

DYNDNS ET ENREGISTREMENTS DNS

Explication des commandes

BLACKLIST: Blackliste les IP des hôtes par réputation

SMTP: Tester le serveur mail SMTP (port 25)

MX: DNS MX enregistrement pour le domaine

A: DNS A enregistre l'IP address pour le nom d'hôte

SPF: Vérifie les enregistrements SPF pour le domaine

TXT: Vérifie les enregistrement TXT pour le domaine

PTR: DNS PTR enregistrement pour le nom de l'hôte

CNAME: DNS Nom canonique du nom de l'hôte name en adresse IP

WHOIS: Permettre de vérifier les informations d'enregistrement

ARIN: Permettre de choisir les informations d'une adresse IP à bloquer

SOA: Get Start of Authority record for a domain

TCP: Verify an IP Address allows tcp connections

HTTP: Verify a URL allows http connections

HTTPS: Verify a URL allows secure http connections

PING: Perform a standard ICMP ping

TRACE: Perform a standard ICMP trace route

DNS: Check your DNS Servers for possible problems [New]

Maintenant comme pour beaucoup de Services SaaS sur le cloud, il faudra payer pour DynDNS.

Lire: comment vous pouvez installer "l'émulation" WAMP sur Windows pour l'utiliser avec DynDns

DynDNS proposait depuis plus de 15 ans, un service gratuit permettant de mapper une adresse IP (même dynamique) avec un sous domaine dyndns.com.

Les raisons officielles de cet arrêt de DNS sont un grand nombre d'abus par les utilisateurs de la version gratuite qui commençait à avoir des répercussions sur les utilisateurs payants, mais aussi un besoin d'économie et de rentabilité afin d'investir pour les utilisateurs payants. Chacun aura le droit à un bon de réduction pour basculer sur la version payante à 25 $ par an. Ce n’est pas cher et si vous en avez vraiment l'utilité, je pense que vous ne devriez même pas hésiter et opter pour la version pro. Maintenant si vraiment vous êtes fâché, et que vous cherchez une solution de DNS dynamique gratuit, voici quelques alternatives.

No IP - C'est une référence après DynDNS.

DtDNS

Dynamic DNS

Free DNS

DuckDNS

DyNS

Certains fournissent des logiciels pour faire l'update. D'autres des scripts et enfin d'autres mettent juste à disposition leur API (Application programing interface). Ils se valent, plus ou moins, donc à vous de voir celui qui vous convient le mieux en remplacement de DynDNS. Par contre, si votre routeur ne propose que DynDNS en option, le passage vers la version payante du service sera obligatoire, à moins de bidouiller le logiciel en ligne de commande et d'y faire tourner vos scripts. Sachez que si vous avez un routeur Dlink, vous avez un DynDNS offert. Même chose si vous utilisez un serveur Synology, la société propose du mapping DNS dynamique. Notez aussi que si vous achetez un domaine chez Gandi, avec leurs API et un peu de code, il est possible de faire des MAJ de zone DNS en live. Même chose chez OVH. Cloudflare permet aussi de faire du DDNS.

OpenDNS détecte les DNS malveillants avec le langage naturel.

Comment sélectionner un fournisseur de "tests d’intrusions"

Résumé sur les revenus générés par la publicité pour les sites connus.

A propos du P2P sur Wedemain.fr de M.Bauwens

"Les multi-nationales à l'assaut de la vie privée" écrit en 2001 par M.Laimé

Pouvez-vous faire confiance à votre ordinateur personnel ?

La neutralité du Net sur La quadrature du net.

![]() Contact :1foplus(at)techalliance (dot) fr

Contact :1foplus(at)techalliance (dot) fr

![]() : 0975858504

: 0975858504

![]() :

33753514880

:

33753514880